Fitur Berkendara Otomatis Mobil Tesla Tidak Selalu Aman?

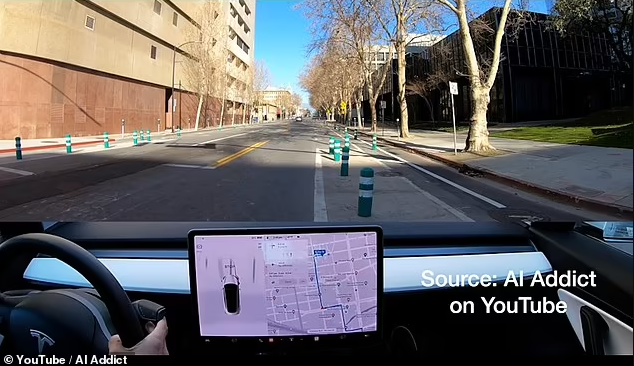

Berita Baru, Amerika Serikat – Sebuah mobil Tesla Model 3 dalam mode berkendara otomatis atau mode “Full Self-Driving” tertangkap kamera bertabrakan dengan tiang pembatas jalur sepeda, hal ini berpotensi menjadi kemunduran bagi Tesla.

Dilansir dari Dailymail.co.uk pada tanggal 25 Februari, rekaman itu diambil saat berkendara di pusat kota San Jose, California, oleh seorang YouTuber bernama AI Addict, dan memberikan bukti rekaman pertama bahwa mode Full Self-Driving, atau FSD, bertanggung jawab langsung atas sebuah kecelakaan tunggal.

Versi terbaru dari perangkat lunak self-driving Tesla, perangkat lunak FSD Beta versi 10.10, dapat dilihat dengan jelas membelokkan mobil Model 3 tersebut ke trotoar yang memisahkan jalur sepeda dari jalan raya.

Meskipun pengemudi menginjak rem dan memutar setir dengan keras menjauh dari rintangan, sistem FSD bertenaga AI menghantam trotoar dengan hantaman cukup keras.

Yang mengkhawatirkan, di titik lain dalam video, Model 3 tersebut tampak menerobos lampu merah dan mencoba menuruni rel kereta api dan kemudian jalur trem karena mode otomatis perangkat lunak tersebut.

Video itu muncul tak lama setelah Tesla terpaksa menarik hampir 54.000 mobil dan SUV bulan ini karena perangkat lunak self-driving mereka memungkinkan mereka melewati rambu berhenti.

Akun AI Addict memposting video sembilan menit perjalanan ke YouTube pada 5 Februari. Kecelakaan itu terjadi sekitar tiga setengah menit.

Sang YouTuber tampak berada di kursi depan di belakang kemudi, ditemani seorang penumpang di kursi belakang.

Akun tersebut dapat terdengar berkata. “Hei Aku menginjak rem dengan penuh ke lantai!”

Penumpang itu berkata: “Saya tidak percaya mobil itu tidak berhenti.”

CEO Tesla Elon Musk hanya mengklaim bulan lalu bahwa sistem FSD versi Beta tidak pernah mengalami kecelakaan, tetapi rekaman baru menawarkan bukti bahwa ini tidak lagi terjadi.

Di sebagian besar video akun AI Addict, pengemudi terlihat hanya menyentuh kemudi daripada memegangnya, memungkinkan teknologi otonom untuk mengontrol pergerakan roda mengikuti rute yang telah ditentukan di peta.

FSD mampu mengendalikan otonomi tingkat 2. Ini berarti sistem dapat mengontrol kecepatan dan arah mobil, memungkinkan pengemudi untuk melepaskan tangan sementara, tetapi mereka harus memantau jalan setiap saat dan siap untuk mengambil alih.

Beberapa saat sebelum kecelakaan, pengemudi terlihat membiarkan kemudi berputar melalui tangannya terlalu jauh ke kanan sebelum melihat tiang dan memutarnya dengan cepat ke kiri, tetapi hal ini sudah terlambat.

Meski tabrakannya tidak terlalu parah, bollard yang nyaris terlempar ke tanah, dan meninggalkan kerusakan di bemper depan.

Mungkin sistem tidak menyadari bahwa ada bagian yang ditutup untuk jalur sepeda. MailOnline telah menghubungi Tesla untuk memberikan komentar.

Model 3 tampaknya memiliki masalah dalam mendeteksi pos penghalang jalur sepeda hijau, yang tersebar di seluruh pusat kota San Jose, di sebagian besar video, sering kali mengemudi ke arah mereka di beberapa titik.

Video tersebut tampaknya menyoroti kekurangan lain di mode FSD, yang masih dalam versi beta dan oleh karena itu diatur untuk memperbaiki kesalahan yang dilaporkan sebelum peluncuran luas.

Di titik lain dalam video, AI mobil mencoba berbelok ke kiri ke jalan utama yang sibuk meskipun sebuah truk sedang melaju.

AI Addict terdengar mengatakan: “Ini truk datang dan itu merayap ke depan dan saya tidak suka ini. Oh Tuhan!.”

Di titik lain, FSD tampaknya melakukan pekerjaan yang baik dengan ‘sabar’ menunggu pejalan kaki menyeberang jalan dan menghindari mobil lain.

Tesla telah merilis pembaruan perangkat lunak baru untuk program Beta FSD, dan yang terbaru adalah versi 10.10, yang dirilis awal bulan ini.

Menjelang akhir tahun lalu, Tesla mengatakan bahwa hampir 60.000 pemilik dalam program Beta FSD, yang hanya tersedia untuk pemilik Tesla terpilih yang dipilih oleh perusahaan dan pengemudi dengan skor keselamatan tinggi 100 dari 100.

Namun, salah satu investor mengungkapkan kepada Electrek Oktober lalu bahwa ia hanya memiliki skor keamanan 37 dari 100 dan masih menggunakan FSD versi Beta.

Skor keselamatan ini ditentukan oleh pengemudi yang memberikan izin perusahaan untuk memantau mengemudi mereka menggunakan perangkat lunak dalam mobil.

Tesla memperingatkan bahwa pengemudi yang menggunakan sistem harus siap untuk campur tangan setiap saat, sesuai dengan sistem mengemudi otonom Level 2.

FSD adalah paket peningkatan ke Autopilot, rangkaian fitur sistem bantuan pengemudi canggih perusahaan, yang memiliki sejarah kontroversial dan seringkali fatal.

Sejauh ini telah 12 kematian yang melibatkan Tesla’s Autopilot telah diverifikasi, bersama dengan banyak kecelakaan yang tidak fatal.

Terlepas dari pernyataan Musk pada Januari tentang catatan sempurna FSD Beta, Administrasi Keselamatan Lalu Lintas Jalan Raya Nasional (NHTSA) pemerintah AS menerima keluhan pertamanya pada November 2021 bahwa FSD menyebabkan kecelakaan dari pengemudi Tesla.

Insiden di Brea, California melibatkan Tesla Model Y yang memaksa dirinya ke jalur yang salah dan ditabrak kendaraan lain, menurut AP.

Rctiplus.com

Rctiplus.com pewartanusantara.com

pewartanusantara.com Jobnas.com

Jobnas.com Serikatnews.com

Serikatnews.com Langgar.co

Langgar.co Beritautama.co

Beritautama.co Gubuktulis.com

Gubuktulis.com surau.co

surau.co